Explainable AI

Explainable AI https://www.digitales-b.de/wp-content/uploads/2023/07/explainable-ai-1024x576.jpg 1024 576 Digitale Geschäftsentwicklung | digitalesB GmbH Digitale Geschäftsentwicklung | digitalesB GmbH https://www.digitales-b.de/wp-content/uploads/2023/07/explainable-ai-1024x576.jpg

Inhalt des Artikels

Explainable AI – eine Definition

Spätestens seitdem ChatGPT den Weg in den Mainstream gefunden hat, ist eine breite Diskussion über den Nutzen, aber auch über die Gefahren von künstlicher Intelligenz entfacht. Auch wenn Wissenschaftler noch über die Dimension von potenziellen Risiken debattieren, so sind sich alle in einem Punkt einig: Die Entwicklung und Anwendung von KI-Systemen muss ein hohes Maß an Verantwortung mit sich bringen. Ein Element für diesen verantwortungsvollen Umgang stellt die Explainable AI dar.

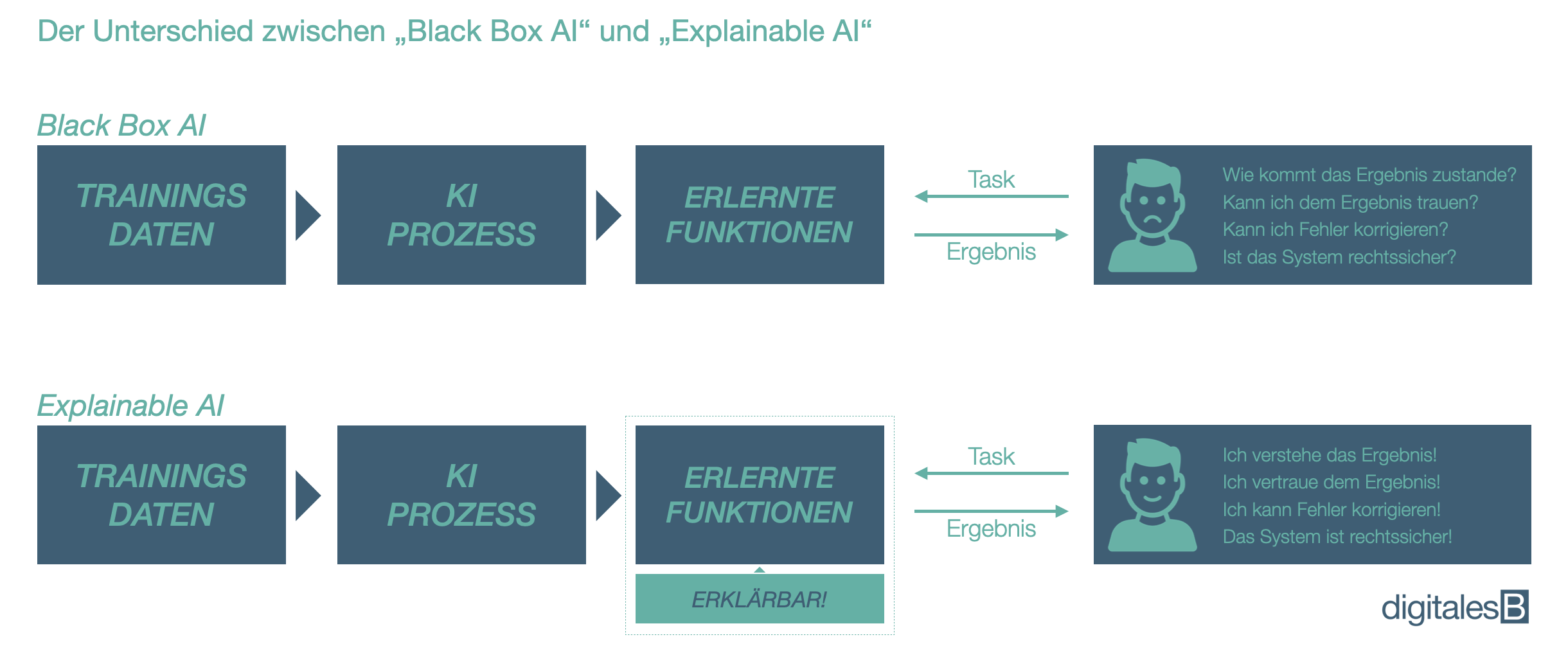

Explainable AI (kurz „XAI“, auch bekannt als „Erklärbare KI“) bezieht sich auf den Bereich der künstlichen Intelligenz, wie KI-Systeme Entscheidungen treffen und wie diese Entscheidungen transparent und nachvollziehbar gemacht werden können. Im Gegensatz zu herkömmlichen Black-Box-Modellen, bei denen die Entscheidungsfindung für den Benutzer unverständlich ist, ermöglicht Explainable AI den Anwendern, die Ergebnisse der KI-Systeme zu verstehen und gegebenenfalls zu korrigieren.

Explainable AI soll also sicherzustellen, dass Ergebnisse von KI-Anwendungen für Nutzer und Betroffene verständlich sind. Dies hat insbesondere bei der Verwertung von personenbezogenen Daten in sensiblen Bereichen wie Finanzen, Recht, Gesundheitswesen oder der öffentlichen Sicherheit eine hohe Relevanz. Somit sollen mögliche diskriminierende Auswirkungen durch die KI unterbunden werden.

Einzugliedern ist XAI in den Bereich der Responsible AI, also der schon erwähnte verantwortungsvolle Umgang mit künstlicher Intelligenz. Hier sind neben Explainable AI weitere Merkmale wie Sicherheit, Vertrauenswürdigkeit, Datenschutz, Verlässlichkeit oder Nachhaltigkeit relevant. Das übergeordnete Ziel von verantwortungsvoller KI ist es demnach, im Einklang mit den Bedürfnissen und Werten der Gesellschaft zu stehen.

Warum können KI-Systeme diskriminierend sein?

Generell muss man sich darüber bewusst sein, dass KI-Systeme keine neutralen oder objektiven Entscheidungen treffen. Sie arbeiten lediglich auf Basis der Daten und Algorithmen, mit denen sie trainiert wurden. KI-Anwendungen können daher diskriminierende Auswirkungen haben, wenn sie auf historischen Daten basieren, die Vorurteile oder Ungleichheiten widerspiegeln, die in der Gesellschaft vorhanden sind. Werden diese Daten dann in das KI-System eingespeist, kann die KI aufgrund der gefundenen Muster, Vorurteile oder Diskriminierungen reproduzieren oder sogar verstärken. Darüber hinaus können genutzte Algorithmen und Modelle auch unbewusste Vorurteile widerspiegeln, die von Entwicklern und Designern eingebettet wurden.

In solchen Fällen spricht man von einem “Bias” einer KI, also einer systematischen Verzerrung einer Anwendung. Das Ergebnis ist dann eine Benachteiligung bestimmter Gruppen oder Individuen bei der Entscheidungsfindung durch die KI-Anwendung. Dabei ist ein Bias in einer KI nicht immer offensichtlich und häufig schwer zu erkennen. Somit ist es von hoher Relevanz, dass Entwickler von KI-Systemen sicherstellen, dass die Programmierung und die verwendeten Trainingsdaten einer KI frei von Vorurteilen und Diskriminierung sind.

Beispiele für Diskriminierungen durch künstliche Intelligenz

Ein typisches Beispiel einer Diskriminierung durch eine KI sind automatisierte Bewerbungsprozesse. KI-Systeme können Bewerber anhand ihrer Erfahrung, Ausbildung und anderer Merkmale bewerten, um eine Auswahlentscheidung zu treffen. Wenn das KI-System jedoch historische Daten nutzt, die eine systematische Diskriminierung von Geschlecht, Rasse oder anderer Faktoren aufweisen, kann das System unbewusst diskriminierende Entscheidungen treffen. Bestimmte Kandidaten können dann aufgrund von Merkmalen abgelehnt werden, die nicht relevant für ihre Fähigkeiten sind. So geschehen bei einem US-amerikanischen Tech-Konzern im Jahr 2018, der durch diese Art von Bias in seinem Bewerbungsprozess systematisch weiße Männer bevorzugt hat.

Ein weiteres Beispiel für einen Bias wurde in einem System des Predictive Policings in den USA festgestellt. Ein KI-System, das zur Vorhersage von Verbrechen eingesetzt wurde, neigte dazu, bestimmte Stadtteile mit höheren Kriminalitätsraten zu benachteiligen. Das System basierte auf historischen Daten, bei denen diese Stadtbezirke in der Vergangenheit eine höhere Kriminalitätsrate aufwiesen. Die Folge war, dass das System in diesen Bereichen eine höhere Polizeipräsenz vorschlug. Somit führte diese erhöhte Überwachung zur Diskriminierung von Minderheiten.

Rechtlicher Rahmen: Der AI Act der EU

Die Politik hat diese Problematik bereits vor einiger Zeit erkannt und steuert mit der Gesetzgebung des sogenannten AI Acts dagegen. Dieser besagt, dass KI-Systeme mit hohem Risiko vor ihrer Markteinführung von einer unabhängigen Stelle zertifiziert und in einer EU-Datenbank registriert werden müssen, um die Überwachung und Durchsetzung der Vorschriften zu erleichtern. Dabei werden KI-Anwendungen in vier unterschiedliche Klassen eingeteilt:

- Unzulässige KI: Diese Kategorie umfasst KI-Systeme, die gegen EU-Gesetze verstoßen, wie beispielsweise Systeme, die die Würde von Menschen verletzen oder diskriminierend sind. Der Einsatz solcher KI-Systeme ist grundsätzlich verboten.

- Niedriges Risiko: Diese Kategorie umfasst KI-Systeme, die nur ein geringes Risiko für die Gesellschaft darstellen, wie z.B. personalisierte Werbung oder Spam-Filter. Diese Systeme müssen nicht zertifiziert werden, aber sie müssen bestimmte Transparenzanforderungen erfüllen.

- Mittleres Risiko: Diese Kategorie umfasst KI-Systeme, die ein höheres Risiko für die Gesellschaft darstellen, wie z.B. KI-Systeme zur Einstellung von Personal oder zur Überwachung öffentlicher Räume. Diese Anwendungen müssen zertifiziert werden und eine Risikobewertung durchlaufen, um sicherzustellen, dass sie transparent, verständlich und sicher sind.

- Hohes Risiko: Diese Kategorie umfasst KI-Systeme, die das höchste Risiko für die Gesellschaft darstellen. Dies sind beispielsweise Systeme zur Steuerung von kritischen Infrastrukturen oder zur Diagnose von schweren Krankheiten. Diese Systeme müssen ebenfalls zertifiziert werden und eine umfassende Risikobewertung durchlaufen. Entwickler solcher Anwendungen müssen dazu eine hohe Sorgfaltspflicht für ihre Anwendungen übernehmen.

Der EU AI Act gilt für alle Unternehmen, die in der EU tätig sind! Dabei spielt es keine Rolle, wo diese KI-Systeme entwickelt wurden.

Welche Modelle von Explainable AI gibt es?

Grundsätzlich gibt es zwei Arten der Erklärbarkeit bei KI-Systemen: Modellbasierte und datenbasierte Erklärbarkeit. Die modellbasierte Erklärbarkeit konzentriert sich auf die interne Struktur des KI-Modells, um Entscheidungen zu erklären, während die datenbasierte Erklärbarkeit auf die zugrunde liegenden Daten des KI-Modells und deren Beziehungen zueinander fokussiert, um Entscheidungen zu erklären. Bekannte Modelle sind beispielsweise LIME (Local Interpretable Model-Agnostic Explanations), SHAP (SHapley Additive exPlanations) oder Grad-CAM (Gradient-weighted Class Activation Mapping).

XAI in der Praxis

Auch wenn beim Thema KI bereits seit mehreren Dekaden an vielen Universitäten oder auch in der Privatwirtschaft geforscht wird, befinden wir uns immer noch in einem sehr frühen Stadium dieser Technologie. Dementsprechend steht die erklärbare KI ebenfalls noch ganz am Anfang.

Fakt ist jedoch, dass große Tech-Konzerne wie z.B. Microsoft, Google oder auch IBM, die eine Führungsrolle bei der künstlichen Intelligenz einnehmen, ihre KI-Anwendungen bereits heute erklärbar gestalten. Dazu werden nicht nur eigene XAI-Modelle geschaffen, sondern Entwickler ebenfalls vorab so geschult, dass ein Bias möglichst gar nicht zustande kommt. Diese Unternehmen sind sich ihrer Verantwortung also bewusst. Die (nahe) Zukunft wird dann zeigen, wie erklärbar und transparent KI-Modelle gegenüber dem Nutzer wirklich sind. Es bleibt spannend!